Mistica dell’algoritmo

Quando la società addomestica le tecnologie le modella ma se ne lascia anche influenzare profondamente, in uno scambio reciproco e continuo

(29 Gennaio 2018)

Cosa cela l’algoritmo? Una metafora. Una sopravvalutazione. Un termine che nasconde non solo la macchina, ma schiere di uomini. E una responsabilità.

Una mail, un collegamento internet, uno specifico browser. E tanto tempo a disposizione, a otto-dieci euro l’ora, per un massimo di venti-trenta ore alla settimana. A pagare, è una società irlandese, o forse maltese, sicuramente anonima e sconosciuta, che però, in un gioco di specchi e scatole cinesi, con tutta probabilità è riconducibile a qualcuno dei grandi dell’informatica. Le varie Google, Facebook e Amazon. Anche in Italia c’è un esercito di anonimi, che lavora conto terzi per “registrare” e “mettere a posto” quello che il computer non può o non riesce a capire. Quando una parola chiave è veramente utilizzata in un determinato sito? Quel video è adatto alla visione di tutti o incita all’odio e alla violenza? Oppure ha, quantomeno, contenuti inappropriati per gli inserzionisti? La notizia condivisa è tale o è palesemente falsa? La testata che la scrive è davvero autorevole?

Gli algoritmi, il frutto più prezioso del computer, per le aziende sono preziosi (e da tutelare) come la proverbiale ricetta della Coca Cola. Ma sono anche il frutto di un’attività di progettazione umana, e come tali i loro architetti hanno una responsabilità che invece, molto spesso, viene cancellata.

Una trasparenza frutto di grande sforzo

Sono domande a cui i software automatici non riescono a dare risposte attendibili. Utilizzare strumenti informatici costerebbe più che far ricorso a una legione di piccole formiche umane, che in tutto il mondo lavorano per correggere costantemente il tiro di sistemi che noi utenti pensiamo del tutto automatici. È il paradosso dell’informatica in rete. In una vignetta che oggi sembra di un milione di anni fa, il New York Times diceva che all’altro capo della chat poteva esserci chiunque, un altro uomo o addirittura un cane (mostrando in effetti un cane che si connette con il pc). Oggi il paradosso è diventato un altro: l’algoritmo che siamo abituati a pensare interagisca con noi potrebbe in realtà essere una persona “travestita” da macchina. Come il barista nascosto dentro il dispenser automatico di caffè, che in quel caso automatico non lo è per niente.

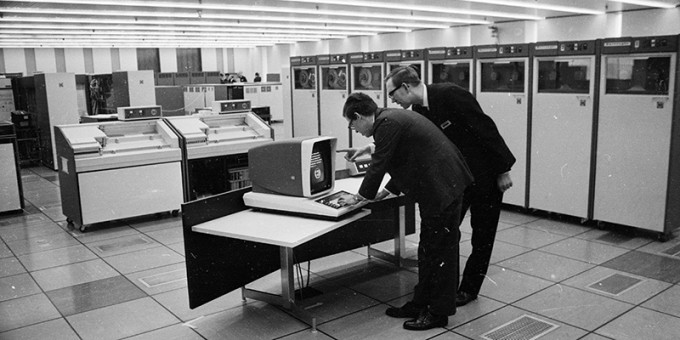

I motivi per cui questo è sorprendente derivano sostanzialmente dal carattere strettamente elitario della cultura informatica: mentre altre scienze come la fisica e la matematica sono diffuse e condivise (tutti per esempio sappiamo più o meno cosa significa la teoria della relatività), quella del computer lo è molto meno. Ne conosciamo la tecnica, perché la incontriamo tutti i giorni, ma di rado i principi. L’esempio classico sono proprio gli algoritmi, il frutto più prezioso del computer, tanto che per le aziende alcuni di essi sono preziosi (e da tutelare) come la proverbiale ricetta della Coca Cola. Ma gli algoritmi sono anche il frutto di un’attività di progettazione squisitamente umana, e come tali i loro architetti hanno una responsabilità che invece, molto spesso, viene cancellata.

Quando l’algoritmo viene antropomorfizzato

Vediamo in concreto cosa significa. Ci sono alcune costanti comuni a tutte le narrazioni sugli algoritmi, parola dal significato sempre più impalpabile nel parlare quotidiano. La prima è che essi siano in pratica “ricette di cucina” per i piatti informatici. Non è vero: la ricetta da cucina lascia margini di interpretazione al cuoco, mentre l’algoritmo tassativamente non prevede ambiguità per l’interprete automatico del computer. È una cattiva metafora.

Wikipedia chiarisce poi che gli algoritmi sono procedimenti per risolvere un problema con un numero finito di passi, e nessuno si esime dal citare l’etimo della parola, che è di derivazione onomastica: algoritmo deriva dal nome del matematico persiano al-Khwarizmi, che li ha “inventati”, o quantomeno battezzati.

Questa la vulgata, che poi assume una forma particolarmente deviante e consolatoria nel modo in cui la nostra società addomestica il feticcio del computer. L’algoritmo è antropomorfizzato e diventa il “genio dentro la bottiglia”, quasi uno spiritello cartesiano che si aggira dentro i computer e li anima di vita propria, distorcendo un aspetto fondamentale delle nostre vite. “Il computer” diventa un soggetto attivo capace di scelte e, con logica tutta umana, anche un alibi e una giustificazione.

Il computer usato come paravento

“Quando qualcuno in un ufficio dice: ‘Questa cosa non si può fare perché il computer non lo permette’”, ricorda Luciano Floridi, filosofo italiano che insegna a Oxford, “in realtà sta usando il computer come paravento e come scusa per non fare. Il computer dovrebbe abilitare nuovi modi di fare, dando più risorse a chi li usa, e non limitarli”.

Ancora, quando accadono cose che non dovrebbero accadere, dalle “bolle” di fake news su Facebook fino ai video che inneggiano alla violenza su YouTube con pubblicità aggregate automaticamente dal “solito algoritmo”, la scusa collettiva è che il piccolo genio automatico si prenda troppe libertà. Sino ad arrivare al problema dell’intelligenza artificiale, che è costruita su algoritmi (come qualsiasi processo informatico) che generano sistemi capaci di decisioni non esplicitamente previste negli algoritmi stessi, sulla base di analisi di dati precedenti. Sono le reti neurali e i sistemi di machine learning, altre parole chiave del nostro tempo, un po’ troppo complesse però per avere la potenza evocativa del misterioso algoritmo.

Le logiche deduttive del software tradizionale

Eppure, le cose non sono affatto complicate, e tantomeno misteriose. L’informatica, con l’eccezione di alcuni sistemi di intelligenza artificiale che affronteremo tra poco, funziona seguendo un modo deduttivo: il computer interpreta le regole generali stabilite dai programmatori e le applica al caso particolare che incontra nell’esecuzione del programma. Queste regole, scritte in uno dei vari linguaggi di programmazione, da un punto di vista astratto sono pensate come algoritmi, cioè come sequenze di passi per risolvere un problema.

L’attività del programmatore non è tanto quella di scrivere parole incomprensibili ai profani sullo schermo del pc, quanto di analizzare i problemi e progettare gli algoritmi per risolverli. E questi algoritmi sono così frutto di un’attività umana al cento per cento. Senza nessuna autonomia. Anzi, ricadono perfettamente nella sfera della responsabilità etica di chi li scrive. E come tali dovrebbero essere conoscibili e verificabili, se non altro dall’autorità pubblica. Esattamente come le formule e ricette brevettate dalle grandi industrie, che vengono tenute segrete ma sono anche testate e verificate da soggetti terzi.

Le logiche induttive dei sistemi di intelligenza artificiale

Il discorso cambia con i sistemi di intelligenza artificiale (AI), che sono comunque limitati a una singola attività per volta (come giocare a scacchi o decodificare la scritta a mano su un foglio digitalizzato), perché ancora siamo ben lontani da una forma di intelligenza artificiale generale, paragonabile alla nostra, che potenzialmente sa risolvere tutti i problemi che le vengono posti. Le AI usano tecniche di programmazione (basate ancora su algoritmi, scritti da analisti e programmatori) per creare sistemi induttivi anziché deduttivi. Le reti neurali, per esempio, sono progettate e addestrate per assorbire grandi quantità di dati e trovare da sole le regole che portano alla soluzione di un determinato problema.

Un esempio concreto: i software per il riconoscimento automatico degli oggetti nelle fotografie (cani e gatti, per esempio), che oggi sono mediamente più bravi di noi nel loro lavoro, sono creati in modo differente da come ci si immaginerebbe. Non sono programmati descrivendo loro tutti i possibili attributi dei cani e dei gatti esistenti (cosa ovviamente impossibile), ma “addestrati” mostrando loro foto di alcuni cani e gatti, in modo che il sistema “capisca” da solo qual è il cane e qual è il gatto e poi sia in grado di riconoscerli.

I programmatori tra etica e responsabilità

In questa maniera però la responsabilità dei programmatori si ferma: non sono più loro che hanno definito ogni passo dei comportamenti del software. E questo i big della tecnologia lo hanno capito benissimo, tanto che, per mitigare i possibili errori che i loro sistemi di AI compiono e che gli algoritmi non possono prevedere, ricorrono spesso a stuoli di esseri umani mal pagati che, uno per uno, devono cercare di correggere il tiro e aggiustare gli sbagli via via che si presentano.

È la frontiera dove le aziende hanno capito molto bene che si fronteggiano etica e responsabilità. Per adesso in singoli ambiti: sistemi di machine learning sono per esempio usati per trovare e leggere in maniera automatica le etichette nei pacchi dei grandi centri di logistica integrata. Invece, quando i grandi della scienza e dell’informatica, come Stephen Hawking e Bill Gates, dicono che non sappiamo come funzionano i meccanismi di apprendimento intendono questo: la procedura di riconoscimento è induttiva e, date determinate precondizioni descritte negli algoritmi del machine learning, è il computer che poi si occupa creare e organizzare le sue categorie. Mancano trasparenza e conoscibilità, e purtroppo mancano anche le strategie per mitigarne gli effetti futuri.